mardi, 22 avril 2014

Collecte de mes données personnelles : est-ce que j'ai des raisons de m'inquiéter ?

Vous pensez :

- je n’ai rien à cacher. Ni à Google, ni à Facebook, ni à PRISM (mais pas peut-être pas à mes proches…).

- je n’ai aucune raison de m’inquiéter :

- je ne suis pas quelqu’un de suspect, si on doit surveiller quelqu’un en tout cas ça ne sera pas moi,

- je veux qu’on me surveille pour me protéger et surtout qu’on surveille les autres pour et faire respecter la loi,

- j’ai confiance en mon gouvernement,

- je n’ai pas à me cacher, je ne fais rien d’illégal,

- je suis prêt à tout pour ma sécurité et celle de mes proches, peu m’importe tant que ce ne sont que des méta-données utilisées pour construire des graphes sociaux et constituer mon profil en agrégeant automatiquement des données.

Vous vous trompez ! Vous allez comprendre de façon très simple et très claire, pourquoi :

- On ignore quelles erreurs de collecte peuvent être faites.

- On ne connait pas les règles qui peuvent faire de nous un suspect idéal.

- Les connaitrait-on, elles devraient être changées pour anticiper de nouveaux comportements.

- Les policiers eux-même refusent d’être surveillés.

- L’absence de confidentialité m’interdit dans certaines circonstances, de témoigner sans me mettre en péril.

- Je ne peux plus un seul instant blaguer, transgresser, déraper, sans que ça puisse un jour m’être reproché.

- Les lois doivent pouvoir ne pas être respectées pour évoluer.

- La vie privée est un besoin humain fondamental.

15:15 Publié dans Numérisation de la société | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook | |

Facebook | |  Imprimer |

Imprimer |

mercredi, 16 avril 2014

Production et analyse de données de masse contre enfermement dans des techniques de surveillance.

“Nous exportons nos données, des données brutes, que nous réimportons sous forme de services. Et ce faisant, nous perdons le cœur de notre valeur ajoutée, le cœur de nos emplois, le cœur de nos services. On est dans une logique d’éviscération par le pillage des données.” Pierre Bellanger

Données personnelles : sortir des injonctions contradictoires

Source http://vecam.org/article1289.html - Valérie Peugeot - Creative Commons

- La première nous a fait scintiller les merveilles associées aux big data, source inépuisable de nouveaux gisements de richesse de l’économie numérique - déluge de données, nouvel or noir, fin de la science… - l’escalade métaphorique semblait sans fin.

- La seconde a été liée au coup de tonnerre déclenché par la suite des révélations d’Edward Snowden : en quelques heures, les cris d’alarme négligés des associations de défense des libertés devenaient réalité, en pire. Nul n’avait anticipé l’ampleur et la diversité des données collectées par la NSA. Si big data il y a, ce sont bien celles interceptées et analysé par les autorités américaines, dans une logique de « big surveillance ».

- Aujourd’hui, troisième vague, nous voyons se multiplier les articles qui tentent de dégonfler l’enthousiasme exagéré suscité par le projet big data, entre démonstration de l’inexactitude des Google Flue Trends et analyse des biais méthodologique du big data (iciet là).

Mais ces critiques ne disent rien du problème précédent : comment dénouer le lien entre production, analyse de données de masse d’une part et logique de surveillance de l’autre. Car c’est bien de cela qu’il s’agit : plus notre économie inventera des services qui auront besoin de s’appuyer sur de la donnée pour fonctionner – et nous en voyons fleurir tous les jours – plus nous mettrons en place les infrastructures passives qui rendent les logiques de surveillance techniquement possibles, quel que soit le tiers qui décide de s’en servir.

De fait, si les critiques du big data se gardent bien d’attaquer la question de la surveillance c’est que, comme beaucoup, ils se trouvent confrontés à un nœud apparemment gordien : vouloir empêcher le recueil de données, c’est bloquer l’innovation, et donc freiner l’économie numérique. Tous les lobbys qui se pressent à Bruxelles autour de la négociation du nouveau règlement en matière de données personnelles ne disent pas autre chose : ne nous empêchez pas d’innover ! Et en l’état, ils ont raison : tout renforcement de la protection des données personnelles peut apparaître comme un frein à la création de nouveaux services. À moins que nous ne changions radicalement notre manière d’aborder le problème.

* * *

Pour commencer, rappelons-nous que de plus en plus de ce qui constitue les big data est et sera de fait de données coproduites par des individus et des services, ce qui signifie que la problématique de la donnée personnelle sera de plus en plus prégnante. Au fur et à mesure que nos objets se mettront à communiquer – compteur, balance, montre, porte d’entrée, voiture etc – nous participeront à cette inflation de la masse de données. Toutes les données ne sont certes pas personnelles (ex : les données météos ne le sont pas), mais de plus en plus de données entreront dans ce régime, ce qui renforce le risque de surveillance.

Face à cela, il nous faut tout d’abord éviter plusieurs impasses.

La première consisterait à rester dans ce que l’on peut qualifier de « faible régime » actuel : de fait nous sommes dans une zone d’incertitude juridique, qui encourage les logiques de « prédation » de la donnée par les plates-formes pour les monétiser, avec des approches plus ou moins délicates (opt in / opt out). Cette situation accule à une vision « innovation contre vie privée », qui pousse le droit, dans une course sans fin, à galoper derrière l’innovation sans jamais être à temps pour protéger les utilisateurs. C’est une approche défensive peu efficace dans une période d’affaiblissement de la puissance publique face aux acteurs du marché. Nous ne pouvons que saluer les dernières prises de position du Parlement européen avec l’adoption en mars dernier du rapport Albrecht concernant le règlement général sur la protection des données, rapport qui rejette les propositions préjudiciables à la vie privée. Mais de fait le rythme du politique et du droit ne sont pas celui de la technologie, et même si le prochain règlement constitue une avancée, il peut en quelques années se révéler impuissants face à de nouveaux dispositifs techniques.

La seconde impasse consisterait à vouloir glisser vers un régime de propriété (intellectuelle et/ ou commerciale) des données par l’utilisateur. Fleurissent actuellement les prises de positions qui vont en ce sens (cf. par exemple la tribune conjointe de Babinet et Bellangerou les prises de position répétées de l’avocat Bensousan). Cette approche me semble à combattre car elle soulève plusieurs problèmes imbriqués :

- un problème de conception politique d’une part : en renvoyant sur l’individu la responsabilité de gérer et protéger ses données, au lieu de trouver des réponses collectives à un problème de société, elle participe d’une vision qui renforce l’individualisme et nie les rapports de force entre les consommateurs et les entreprises

- conséquence du point précédent, surgit un problème très concret : ceci déboucherait sur un renforcement des inégalités entre citoyens numériques, entre ceux en capacité de gérer leurs données, de les protéger, les monétiser, et ceux qui par manque de littératie, de temps, ou toute autre raison, laisserait faire par défaut le marché.

Le scénario plausible qui se met en place est celui d’une société numérique dans laquelle les personnes en bas de l’échelle économique et/où culturelle commercialisent leurs données (pas forcément sous forme monétaire, mais en échange de services), pendant que ceux qui disposent de moyens économiques et/où culturels les enferment à double tour numérique. C’est déjà ce qui se met en place (ex : Doodle) ou se profile (ex : YouTube, Apple) avec des services premiums payants sans publicité.

Finalement ce choix entre deux moyens de paiement pour l’accès à un même service (monétisation directe versus attention) ne serait pas un problème en soi si la circulation des données de l’utilisateur ne soulevait pas chaque jour un peu plus des problèmes de vie privée.

Sans compter que ce régime n’offre pas de garantie de non traçage à l’image de ce qui se pratique avec le « do not track » (dont l’interprétation par les grands opérateurs publicitaire laisse dubitatif : la collecte de données reste active, certes sans utilisation directe par la publicité sur le navigateur concerné, ce qui n’empêche pas à leurs yeux la revente sur des places de marché de données).

- Ce scénario de la propriété sur les données est poussé par des acteurs qui y voient une opportunité d’affaires plus qu’une sortie par le haut dans une économie numérique en recherche d’équilibre. On voit ainsi apparaître des entreprises qui promettent aux internautes une monétisation directe de leurs données en les louant à des tiers (ex : Yesprofile). Ces acteurs ont pour l’heure un positionnement ambigu : ils promettent simultanément une reprise de contrôle sur les données par l’utilisateur et une source de revenus. S’ils partagent avec les acteurs du VRM (Vendor Relationship Management) le premier objectif, la promesse financière les en démarquent. Cette promesse financière semble illusoire, les simulations montrant un taux de retour de quelques euros, mais ce n’est pas la question essentielle. Dans cette approche, la régulation ne passe que par un modèle commercial, entre entités en situation d’asymétrie informationnelle et de rapport de force, ce qui se traduit inévitablement au désavantage du consommateur/utilisateur.

- À l’inverse, si comme nous le pensons, cette monétisation directe des données par les individus génère des revenus anecdotiques, on peut imaginer de voir émerger un autre type d’intermédiaires qui se chargeraient non plus de la commercialisation mais de la « gestion protectrice de données numériques », c’est à dire de la vérification de qui collecte, qui en fait quoi. De la même manière que des entreprises se sont positionnées sur le marché de la réputation et proposent aux internautes des services de « nettoyage » de réputation (ex : RéputationVIP), d’autres pourrons se positionner sur la gestion protectrice. Là encore, certains utilisateurs pourraient se payer les services de ces « gestionnaires de données », pendant que d’autres devraient laisser leurs données circuler au bon vouloir des plates-formes et de leur marché secondaire de la donnée. Nous rebouclons ainsi avec la question des nouvelles inégalités numériques induites par un glissement d’un régime de droit vers un régime de propriété.

- Par ailleurs, scénario du pire, si le choix était fait d’un passage en régime de propriété intellectuelle, cela supposerait, par analogie avec le droit d’auteur ou le brevet, que le droit exclusif de l’individu sur ses données soit temporaire. En effet par définition les régimes de propriété intellectuelle sont des exceptions de monopole concédées à un créateur ou un innovateur, délai au terme duquel les données passeraient dans le domaine public. On voit bien ici qu’un régime de propriété intellectuelle est totalement inapproprié : au bout de quel délai les données sortiraient-elles de la propriété de leur (co)producteur qu’est l’utilisateur ? Au moment où elles n’ont plus de valeur sur le marché de l’économie de l’attention ? De plus le droit d’auteur ne fonctionne que parce qu’il est assorti de nombreuses limites et exceptions pour des usages dits légitimes (recherche, éducation…). Est-ce que l’usage des données serait lui aussi « légitime » quand il est fait sous forme de statistiques agrégées (génomique par exemple ?).

- De plus cela risque de pervertir la logique du droit de propriété intellectuelle : actuellement les informations brutes et les données ne sont pas couvertes ; le droit d’auteur ne concerne que la forme que l’on donne aux informations, et en Europe, le droit sui generis rend propriétaire la cohérence dans une base de donnée, et non les données elles-mêmes. En élargissant aux données personnelles, on risque de provoquer un glissement général vers une mise sous propriété de toutes les données et informations brutes, ce qui aurait des conséquences sur les données scientifiques, publiques… Très exactement l’inverse de ce que nous défendons avec l’open data, la science ouverte etc.

- Une alternative avancée par certains serait la mise en place de sociétés de gestions des droits sur les données, à l’image des sociétés de gestion de droits d’auteurs. Outre le fait que les sociétés de gestion de droits d’auteurs sont loin d’être la panacée et sont régulièrement critiquées (cf. par exemple JF Bert), cette solution semble totalement irréaliste. Alors que sur les œuvres, les coûts de transaction pour la redistribution des droits aux auteurs sont tels que par exemple 68% des sociétaires de la SACEM ne reçoive aucune rémunération, on a du mal à imaginer un système de redistribution, même numérique, de quelques euros entre des millions d’utilisateurs.

La troisième fausse piste, réside dans les solutions techniques de type cryptographie

Pour l’heure plusieurs acteurs poussent aux solutions techniques. Il s’agit essentiellement des acteurs institutionnels (cf. les déclarations du premier ministre à l’ANSSI en février) et des acteurs venus des communautés technologiques (IETF, W3C, etc.) dont c’est le métier (cf. les nombreux papiers scientifiques proposés à la rencontre STRINT de Londres). Si pour ces derniers, il est cohérent d’aller dans cette direction puisque c’est là que réside leur savoir-faire et leur gagne-pain, il est plus surprenant de voir des acteurs politiques dépolitiser ainsi une question aussi centrale. • La réponse technique à un problème rendu possible par la technique est une course en avant sans fin, qui tend à éluder le fait que le numérique est un produit éminemment socio-technique. Pas plus que les DRM ne sauvent des industries culturelles qui refusent de prendre la mesure de la profondeur de la mutation à l’œuvre en matière de circulation des œuvres, la cryptographie ou autre solution technique ne saurait être une réponse à une problématique socio-économique. • Il y aura toujours une technologie capable de défaire la précédente. Jusqu’à présent aucun verrou numérique n’a su résister. De plus, comme le rappelle très justement Snowden « « Le chiffrement fonctionne […]. Malheureusement, la sécurité au point de départ et d’arrivée [d’un courriel] est si dramatiquement faible que la NSA arrive très souvent à la contourner. » Et rappelons-nous que la NSA (ou ses consœurs) installe des backdoors dans les logiciels de chiffrement eux-mêmes.

* * *

Alors que pouvons-nous envisager pour nous prémunir de la société de surveillance tout en continuant à créer, inventer ?

Voici quatre pistes, qui sont autant d’invitation à débattre.

La première piste consiste à orienter l’économie numérique le plus loin possible de l’économie de l’attention pour revenir à une économie servicielle. Aujourd’hui l’économie du Web repose en très grande partie sur une monétisation de « notre temps de cerveau disponible » via de la publicité pour nous inciter à consommer. Google, Facebook, Twitter, et même Amazon qui pourtant commercialise des biens, vivent sur des marchés dits bifaces ou multifaces : d’une main ils offrent un service non monétisé (moteur de recherche, microblogging, réseau social…), de l’autre ils revendent les traces de leurs utilisateurs soit en direct à des annonceurs, soit via des places de marché de la donnée sur lesquelles opèrent des data brokers. Parmi les plus gros opérateurs aux États-Unis on peut citer Axicom, dont on estime qu’elle dispose d’environ 1500 informations sur 200 millions d’américains ou encore Epsilon, BlueKai, V12 Group, Datalogix. Ce déport d’une part croissante de l’économie semble sans fin : un jour c’est un banquier qui émet l’idée de ne plus faire payer les frais de carte bancaire aux clients en échange d’un droit de réutilisation de leurs données ; demain ce sera un organisateur de concert qui vendra des entrées à bas prix en échange d’un accès aux données du spectateur, etc. En raisonnant par l’extrême, si des secteurs entiers de l’économie pré numérique se mettent à basculer vers cette illusion du gratuit et à commercialiser de la donnée en sus et place d’un bien ou d’un service, à qui les data brokers revendront-ils leurs données ? Cette information ne perdra-t-elle pas progressivement de la valeur au fur et à mesure que des pans entiers de l’économie basculeront vers des marchés bifaces basés sur l’attention ? Sans aller jusqu’à cet extrême, il nous faut aujourd’hui inverser trois choses : sortir de l’illusion que ce qui est gratuit pour le consommateur est bon pour lui ; revenir autant que faire se peut à de la commercialisation de services, ce qui participe à désenfler la tentation de captation des données personnelles (en ce sens, les services dits d’économie collaborative, en se rémunérant pour la plupart par un pourcentage sur la prestation sur le covoiturage, sur l’hébergement…, au lieu de pratiquer l’illusion de la gratuité assortie de publicité, participent à une forme d’assainissement de l’économie numérique) ; encadrer très fortement les marchés de data brokers, qui sont aujourd’hui totalement opaques et non régulés. Le marketing prédictif est le meilleur ami de la surveillance car il recueille et traite les données toujours plus fines sur l’individu qui rendent cette dernière techniquement possible. Tout ce qui peut contribuer à affaiblir ce marché est bon pour notre société et les libertés individuelles.

Plus généralement, une régulation du marché des données, si l’on considère la transparence comme élément d’un contrôle social de l’usage des données, peut passer par une obligation de documentation technique très forte – quelles données collectées, où sont-elles stockées, combien de temps sont-elles conservées, … ? –. Cette documentation serait le support à l’intervention d’un corps d’inspecteurs des données, dont les prérogatives iraient bien au-delà de celles de la CNIL. C’est, dans un tout autre domaine, ce qui vient d’être fait par la justice américaine, qui a condamné Apple à être surveillé pendant 2 ans, suite à des pratiques d’entente illicite sur les livres numériques. Le principe met toutes les entreprises à égalité puisque celles-ci ont la responsabilité d’appliquer par défaut le bundle of rights, mais peuvent être soumises à des audits aléatoires.

La seconde piste est certes technique, mais à l’opposé de la cryptographie, va chercher du côté des infrastructures ouvertes et libres (au sens logiciel du terme). Il s’agit, première brique, autant que possible d’utiliser des logiciels libres car ils assurent une surveillance horizontale par les communautés de ce que fait et comment peut être utilisé un logiciel, comme le rappel l’APRIL dans sa tribune dans Libération du 25 février 2014. La transparence du logiciel libre et sa capacité d’appropriation par d’autres que ses concepteurs initiaux en fait une brique d’une reconstruction d’une relation de confiance entre l’utilisateur et un logiciel. Mais au-delà des logiciels, ce sont aussi les normes qui doivent être pensées sur un modèle ouvert, pour qu’elles ne deviennent pas de nouvelles boites noires génératrice d’insécurité sur les données (en laissant une poignée d’acteurs nord-américains prendre le leadership de cette normalisation, nous n’en prenons pas le chemin). Ceci est particulièrement vrai pour les normes encore à construire pour l’internet des objets. Si nous laissons s’installer des standards propriétaires, nous donnons le fer pour nous faire battre. On peut aller plus loin en suivant les pistes de Van Kranenburg dans son rapport sur l’internet des objets où il propose d’aller vers des infrastructures globales ouvertes, depuis le RFID jusqu’au GPS (page 50 du rapport). Sur la base de ces infrastructures on peut alors imaginer des outils de gestion de sa vie privée comme ce RFID Guardian, imaginé par Melanie Rieback (page 49 du rapport) qui permet de régler l’usage du RFID quand on circule dans un environnement connecté (supermarché, ville…). Il s’agit enfin et surtout pour protéger nos données personnelles, de construire des infrastructures de management de ces données qui redonnent la main et le contrôle à l’utilisateur, infrastructures que certains appellent les PIMS – Personal information mangement systems, à l’instar de ce que développement une entreprise comme Cozy cloud.

La troisième piste, qui déborde le cadre stricte des données personnelles pour s’intéresser aux données numériques en général, consiste, en s’inspirant des travaux d’Elinor Ostrom et de l’école de Bloomington autour des biens communs, à développer une sphère de données en Communs, c’est-à-dire de données qui peuvent être considérées comme une ressource collective, et qui n’entrent ni dans le régime des biens gérés par la puissance publique strico sensu, ni dans un régime de marché. Ce régime de Communs repose sur une gestion par une communauté de la ressource considérée, qui organise ses règles de gouvernance, en s’appuyant sur un « faisceau de droits » (bundle of rights »). Ces faisceaux de droits rendent possibles des régimes de propriété partagée. Un faisceau de droit c’est un ensemble de relations sociales codifiées autour de quelque chose à protéger comme le rappelle Silvère Mercier. Ils permettent de penser les usages indépendamment de la notion de « propriété », et d’adapter les règles de droit pour servir au mieux les usages en protégeant les ressources mises en partage. La grande force des Communs est d’ouvrir une troisième voix à côté de la propriété privée et de la propriété publique, un espace dans lequel des ressources, ici des données, ne sont pas soumises à un régime de droits exclusifs, mais peuvent être réutilisées selon certaines conditions fixées par la communauté qui en a la gestion et qui veille à leur protection. Il ouvre un espace protégé dans lequel les individus et les collectifs peuvent choisir de placer leurs données.

Ces ressources sont ainsi soustraites au marché stricto sensu et aux logiques oligopolistiques qui sous-tendent le capitalisme que nous connaissons dans sa forme actuelle. Ce qui ne signifie pas que des porosités n’existent pas avec le marché ou que les Communs se font contre le marché. Les deux peuvent non seulement cohabiter mais également se compléter. Ainsi Flickr, plateforme de partage de photos, filiale de Yahoo !, héberge des photos placées par des internautes en régime de Communs via une licence Creative Commons, de même que des fonds d’archives photographiques du domaine public placées là par des institutions publiques (musées, bibliothèques...). De même ces ressources échappent au régime de pure administration publique qui laisse reposer l’entière responsabilité de leur gestion et de leur protection sur les épaules de la puissance publique. Les Communs impliquent une co-responsabilité de la part des acteurs qui en assurent la gouvernance, permettant ainsi un glissement de logiques purement délégatives à des approches plus contributives. De la même manière que pour le marché, sphère publique et Communs n’ont pas vocation à s’opposer mais à se compléter. Ainsi lorsqu’une communauté d’habitants en Bretagne décide de mettre en place et d’autofinancer en crowdfunding une éoliennesur leur territoire pour assurer une fourniture d’énergie autonome et durable au village, tout en utilisant un terrain de la municipalité, le Commun est coproduit par cette dernière et par les habitants, et se réalise en partenariat avec les entreprises privées qui vont construire l’éolienne et gérer les flux électriques sur les réseaux, sous le contrôle des citoyens qui auront financé le projet.

Pour éviter que l’ensemble des données ne soient pas aspirées dans cette course à la marchandisation de la donnée et favorise ainsi une société de surveillance, il est essentiel qu’une sphère de données « en Communs » puisse fleurir, s’enrichir et être protégée contre des tentatives d’enclosures.

L’existence de cette sphère de données en Communs présente plusieurs avantages : elle constitue un gisement d’informations dans laquelle d’autres acteurs extérieurs à la communauté des producteurs peuvent puiser pour créer, innover, proposer d’autres services ; elle permet de tirer parti des spécificités contributives du monde numérique

* * *

Quelles données pourraient appartenir à cette sphère des communs ?

Trois catégories semblent possibles en premier regard :

- Des données produites par la sphère publique et partagées en open data, sous réserve qu’elles soient assorties d’une licence de partage à l’identique (share alike). C’est déjà le cas de la licence choisie par un grand nombre de collectivités locales mais à notre grand regret pas par Etalab, ce qui veut dire que ces données peuvent être à nouveau « encloses ». Les données produites pas la puissance publique avec l’argent public doivent rester libres de réutilisation.

- La seconde catégorie est constituée des données produites par les individus qui désirent placer ces ressources en bien commun. C’est déjà le cas des données produites dans OpenStreetMap, dans Wikipédia, qui de fait constituent une œuvre collective, pour lesquelles les communautés ont choisi un régime juridique qui protège les ressources en biens communs. Sur Wikipédia la communauté a fait le choix de deux licences compatibles, la licence CC by-sa et la licence de documentation libre GNU, qui dans les deux cas contiennent cette obligation du partage aux mêmes conditions.

- Dans une moindre mesure, des données produites par des entreprises pour les besoins de leur activité – un catalogue de magasin, une liste de point de vente, un taux de fréquentation de ses magasins – et qui choisissent de les mettre à disposition de tiers dans une logique écosystémique. C’est ce qu’ont commencé à faire la SNCF ou La Poste, qui expérimentent autour de l’open data. Je dis dans une moindre mesure, car les données des entreprises peuvent à tout moment être ré-enfermées (ex : via une fermeture d’API comme l’a fait Twitter) et ne font pas l’objet d’une gouvernance collective, mais d’une gouvernance privée par l’entreprise qui décide de les mettre à disposition. On peut craindre, comme cela s’est déjà passé pour d’autres services numériques, qu’une fois l’écosystème constitué, les données ne redeviennent privées, l’ouverture ne constituant alors qu’une phase transitoire, un « produit d’appel ».

La quatrième piste, proche dans sa source d’inspiration de la précédente, consiste à imaginer une gestion des données personnelles par un régime de « bundle of rights ». Le Bundle of rights, ou « faisceaux de droits » puise à un courant juridique qui a émergé aux États-Unis au début du XXe siècle et qui trouve ses racines dans la pensée juridique américain dite du « legal realism » (ou réalisme juridique) qui conçoit la propriété comme un ensemble complexe de relations légales entre des personnes, ainsi que l’explique Fabienne Orsi. Cette approche par le « faisceau de droits » permet, autour d’une même ressource matérielle ou immatérielle, d’identifier différents droits : ex : droit de posséder, d’utiliser, de gérer, de monétiser, de transmettre, de modifier… Cette approche est un des piliers de la pensée des Communs.

Appliqué aux données produites sur le web par les actions des individus, les faisceaux ou bouquets de droits permettraient d’imaginer trois ensembles de droits :

- Certains usages assortis de droits sont garantis par défaut à l’utilisateur, comme par exemple, le droit de savoir ce que l’on collecte sur lui ; le droit de rectification de ses données ; le droit à la portabilité des données ; le droit de placer ses données en Communs (cf. supra).

- D’autres usages peuvent être à l’inverse garantis à la plate-forme, au producteur du service, comme par exemple le droit de gestion pour une amélioration de la relation client ;

- Enfin, les usages intermédiaires qui sont ceux qui dégagent le plus de valeur d’usage à la fois pour l’entreprise et pour l’individu (ex : le graphe social) peuvent quant à eux faire l’objet d’un usage par l’entreprise sous deux régimes possibles :

- Une ouverture de la donnée individuelle à un tiers sur base d’une autorisation explicite de la part de l’individu coproducteur, en échange d’un service ex : j’autorise une marque d’électroménager à accéder à mes données pour me proposer une machine à laver qui correspond à mes besoins, dans une approche dite VRM – Vendor relationship management. Cette approche fait l’objet d’une expérimentation à travers le projet MesInfos, porté par la FING.

- Une ouverture de la donnée agrégée et anonymisée à des tiers sous condition de partage limité dans le temps. Sur une très courte période, quand la donnée est « chaude », la plateforme aurait le droit de monétiser celle-ci agrégée à d’autres, mais à l’expiration de cette période, la donnée ne pourrait plus être mobilisée directement ou indirectement par la plateforme productrice. La donnée devrait alors soit être détruite (pas de possibilité de stockage) soit être transférée vers un espace de type cloud personnel où l’individu pourrait la conserver s’il la juge utile, voire la partager s’il le souhaite.

Cette approche par une discrimination à la fois temporelle des droits (donnée chaude, droits d’usage à l’entreprise, donnée froide, exclusivité de l’usager) et spatiale (stockage dans la plateforme, stockage dans un espace contrôlé par l’individu) pourrait ouvrir la voir à un bundle of rights positif, c’est-à-dire à la fois protecteur pour l’individu et en même temps ne tuant pas d’entrée de jeu le modèle d’affaires des entreprises du web qui proposent des services (hors marketing) construits autour de la donnée (ex : trouver un vélib).

Enfin, de façon encore plus prospective, pour aller plus loin dans la réflexion, nous ne voulons pas placer ce régime d’usage sous le signe de la propriété partagée mais sous celui d’un nouveau « droit du travail contributif ». En 1936 Jean Zay avait défendu dans une loiqui n’a pas pu voir le jour à cause d’une opposition des éditeurs puis de l’explosion de la Seconde guerre mondiale, une conception du droit d’auteur basée non pas sur un régime de propriété intellectuelle mais sur la reconnaissance du travail accompli. Cette approche avait pour objectif de protéger les créateurs tout en défendant le domaine public, source de renouvellement créatif dans lequel puisent les nouvelles générations d’artistes (domaine public que l’on peut considérer comme l’une des composantes d’une sphère des Communs). En considérant l’auteur non plus comme un propriétaire, mais comme un travailleur, cette approche permettait à Jean Zay de dissocier les droits des descendants sur d’une part le droit moral à longue durée, et d’autre part les droits patrimoniaux pour lesquels il séparait (forme de bundle of rights) le droit à percevoir des revenus par les ayant-droits, qui devaient durer jusqu’à ce que l’œuvre entre dans le domaine public, de l’existence d’un monopole sur l’usage de l’œuvre, qui pour sa part était limité à dix ans après le décès de l’auteur, permettant ainsi aux œuvres de faire l’objet de nouvelles exploitations rapidement.

Dans le cas qui nous occupe, si l’on accepte les hypothèses suivantes :

- que le Web des données est le fruit du labeur conjoint des plates-formes et des utilisateurs, comme c’est affirmé entre autres dans le rapport Colin et Collin ;

- que le travail est en train de muter profondément à l’heure du numérique, effaçant la frontière entre amateur et professionnel ;

- que les travailleurs vivant hors du système classique du salariat vont se massifier …alors nous devons inventer ce droit du travail contributif qui pourrait s’appuyer sur un bundle of rights adapté à la nouvelle situation.

*****

Refus de la propriétarisation de la donnée, déplacement du capitalisme informationnel vers une économie servicielle, montée en puissance des infrastructures ouvertes de recueil et traitement des données personnelles, développement d’une sphère des données en régime de Communs, construction d’un droit des données personnelles appuyé sur un « faisceau de droits d’usage »... Chacune de ces pistes vise à empêcher la construction d’une société de surveillance. Certaines sont déjà en cours d’exploration. A nous de multiplier les recherches et de faire se rencontrer les acteurs qui œuvrent à une sortie par le haut de la société des données de masse. Pour que données puisse rimer avec libertés.

* * *

Posté le 13 avril 2014

©© Vecam, article sous licence creative common

Articles cités

1) Eight (No, Nine!) Problems With Big Data

- The first thing to note is that although big data is very good at detecting correlations, especially subtle correlations that an analysis of smaller data sets might miss, it never tells us which correlations are meaningful.

- Second, big data can work well as an adjunct to scientific inquiry but rarely succeeds as a wholesale replacement.

- Third, many tools that are based on big data can be easily gamed. For example, big data programs for grading student essays often rely on measures like sentence length and word sophistication, which are found to correlate well with the scores given by human graders. But once students figure out how such a program works, they start writing long sentences and using obscure words, rather than learning how to actually formulate and write clear, coherent text. Even Google’s celebrated search engine, rightly seen as a big data success story, is not immune to “Google bombing” and “spamdexing,” wily techniques for artificially elevating website search placement.

- Fourth, even when the results of a big data analysis aren’t intentionally gamed, they often turn out to be less robust than they initially seem. Consider Google Flu Trends…

- A fifth concern might be called the echo-chamber effect, which also stems from the fact that much of big data comes from the web. Whenever the source of information for a big data analysis is itself a product of big data, opportunities for vicious cycles abound.

- A sixth worry is the risk of too many correlations. If you look 100 times for correlations between two variables, you risk finding, purely by chance, about five bogus correlations that appear statistically significant — even though there is no actual meaningful connection between the variables.

- Seventh, big data is prone to giving scientific-sounding solutions to hopelessly imprecise questions.

[…] Big data can reduce anything to a single number, but you shouldn’t be fooled by the appearance of exactitude. - FINALLY, big data is at its best when analyzing things that are extremely common, but often falls short when analyzing things that are less common. {…] But no existing body of data will ever be large enough to include all the trigrams that people might use, because of the continuing inventiveness of language (à moins que d’abondantes inventions soient proposées par des machiutomates , et que les humains se contentent d’adopter certains choix des machines …).

2) Big data: are we making a big mistake?

3) Les Échos : La propriété des données, défi majeur du XXIe siècle par Benoît Georges (13 février 2014)

Si les données sont l’or de l’ère numérique, comment contrôler leur exploitation par les géants d’Internet ? Pierre Bellanger, PDG de Skyrock, et Gilles Babinet, représentant de la France à Bruxelles pour les enjeux numériques, viennent de publier deux livres sur ce sujet. Le premier milite pour une souveraineté nationale, quand le second préfère une régulation mondiale.

Selon vous, est-ce que l’on est encore au tout début de cette histoire ?

- […]

- GB : Si on fait des comparaisons avec la première ou la deuxième révolution industrielle, nous ne sommes qu’au tout début, c’est-à-dire au moment où les masses commencent à adopter les techniques, ce qui entraîne une accélération de l’innovation. Le phénomène est exponentiel, et c’est un moment unique de l’histoire de l’humanité.

Aux Etats-Unis, cette notion d’exponentiel s’accompagne souvent d’un discours expliquant qu’il ne sert à rien de réguler un mouvement si rapide. Or la nécessité d’une régulation est au cœur de vos deux livres…

-

[…]

-

P. B. : Dans ce que dit Gilles, il y a deux choses qui m’arrêtent. D’abord l’affirmation, comme une évidence, de la fin des souverainetés nationales. Je pense qu’il n’y a pas de liberté sans droit, et qu’il n’y a pas de droit sans souveraineté. Or la souveraineté est géographique, au sens que l’expression de la souveraineté est le droit d’une population qui vote démocratiquement ses lois sur un territoire donné.

La deuxième chose concerne le laisser faire. Quand on étudie le complexe militaro-numérique américain, dont les intérêts de recherche scientifique, de subventions, d’aides sont coordonnés, on a affaire à une logique qui est bien plus administrée qu’elle ne l’est en Europe. L’attrape-bobo libertaire fait que l’on s’émerveille devant des start-up qui seraient nées dans des garages. On oublie juste de dire que le garage se trouve en fait sur un porte-avions !

Quelle peut être la place de l’Europe aujourd’hui, alors que les plates-formes logicielles sont développées aux Etats-Unis et que les appareils pour y accéder viennent d’Asie ?

- P. B. : Aujourd’hui, la place de l’Europe, c’est le buffet gratuit où l’on vient se servir. L’image qu’on peut reprendre, c’est celle de la bataille qu’a menée l’Inde au début du XXe siècle pour retrouver sa souveraineté sur le coton.

L’Inde était un grand producteur de coton et, lorsque les Britanniques ont conquis l’Inde, ils ont rapatrié l’industrie en Grande-Bretagne pour réexporter le coton tissé vers l’Inde. Toute la bataille de Gandhi a été de récupérer ce filage du coton et cette souveraineté. Aujourd’hui, le coton du XXIe iècle, ce sont les données.

Nous exportons nos données, des données brutes, que nous réimportons sous forme de services. Et ce faisant, nous perdons le cœur de notre valeur ajoutée, le cœur de nos emplois, le cœur de nos services. On est dans une logique d’éviscération par le pillage des données.

4) Blog du Figaro : La propriété des données par Alain Bensoussan (18 mai 2010)

Majoritairement, les individus s’expriment en marquant leur possession sur leurs données personnelles en disant « mon nom, mon adresse, mes informations ». Cette pratique est en quelque sorte « orthogonale » aux règles de droit.

En France, comme dans de nombreux pays, la notion de propriété des données n'a pas de statut juridique en tant que tel.

La propriété ne peut porter que sur la création intellectuelle de ces données (propriété intellectuelle telle que droit d'auteur, droit des marques, brevet), relever du domaine des informations « réservées » (car confidentielles), ou encore appartenir à des personnes physiques parce que constituant des données sur leur personne ou sur leur vie privée, et faire précisément l’objet d’une protection à partir des droits de la personnalité, à l’exclusion de tous droits de propriété. Il en est ainsi notamment du droit à l’image, du droit à la voix et du droit à la protection de sa vie privée.

Les droits de la personnalité ont été renforcés par la loi Informatique et libertés et la directive 95/46 relative à la protection des données à caractère personnel.

5) L’inexactitude des Google Flue Trends

Google n'a pas voulu commenter les difficultés de cette année. Mais plusieurs chercheurs suggèrent que les problèmes seraient dus à une large couverture médiatique de la grippe US cette année, y compris la déclaration d'une urgence de santé publique par l’État de New York le mois dernier. Les rapports de presse ont peut-être déclenché de nombreuses recherches liées à la grippe par des gens qui ne sont pas malades. Peu de doute que Google Flu va rebondir dès que ses modèles seront raffinées.

"Vous devez être en constante adaptation de ces modèles, ils ne fonctionnent pas dans le vide», dit John Brownstein, un épidémiologiste à la Harvard Medical School à Boston, Massachusetts. "Vous avez besoin de les recalibrer chaque année."

6) Adoption en mars dernier du rapport Albrech

- Paris, 12 mars 2014 — Le Parlement européen vient d'adopter en première lecture le rapport de Jan Philipp Albrecht concernant le règlement général sur la protection des données.

- Les eurodéputés sont finalement parvenus à résister aux pressions des lobbys et ont rejeté la plupart de leurs propositions préjudiciables.

- Bien que d'importants progrès ait été réalisés aujourd'hui, les dangereuses notions d'« intérêt légitime » et de « données pseudonymisées » ont été conservées, et pourraient empêcher le texte définitif de protéger les citoyens de manière effective.

7) Les Echos : La propriété des données, défi majeur du XXIe siècle

Une société numérique dans laquelle les personnes en bas de l’échelle économique et/où culturelle commercialisent leurs données , pendant que ceux qui disposent de moyens économiques et/où culturels les enferment à double tour numérique :

- Doodle (http://fr.wikipedia.org/wiki/Doodle.com) Doodle.com permet la création de sondages dont les options peuvent être quelconques ou des dates. C'est dans cette dernière fonction, dite encore de "synchronidateur", que le site est le plus utilisé, afin de déterminer une date ou horaire convenant à un maximum de participants. Une des caractéristiques du site est l'accès sans inscription ni connexion, tant pour le créateur du sondage que pour les participants.

Modèle économique[modifier | modifier le code] Doodle.com a plusieurs sources de revenus :

- Les annonces publicitaires présentes sur le site3.

- Un service premium à destination des particuliers et des entreprises4. - YouTube : Les utilisateurs de YouTube pourraient toujours accéder gratuitement au vaste catalogue de musique et de vidéos musicales du site mais ils auraient l'option de payer pour un service "premium", sans publicité, qui offrirait en outre des extras, comme la possibilité de stocker les morceaux pour pouvoir les écouter sans être connecté à Internet.

- Apple :La société négocie avec les opérateurs du câble et les chaînes de TV pour mettre sur pied un service qui permettrait de regarder ses programmes, sans publicité, moyennant un abonnement. {…] Ces abonnements seraient ensuite en partie reversés aux groupes médias et opérateurs du câble. Un business model freemium qui n'est pas sans rappeler celui mis au point pour son service de streaming musical, iTunes Radio, qui sera disponible dans une version gratuite financée par la publicité et une version payante, à 24,99 euros par an, dépourvue de toute publicité.

8) Yesprofile : Monétisation directe des données en les louant à des tiers. Redevenez propriétaire de vos données personnelles.

9) VRM (Vendor Relationship Management)

10) RéputationVIP Service de « nettoyage » de réputation.

11) Solutions techniques de cryptage :

- déclarations du premier ministre à l’ANSSI en février

- papiers scientifiques proposés à la rencontre STRINT de Londres

15:59 Publié dans Gouvernance, Numérisation de la société, Rapports de force | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook | |

Facebook | |  Imprimer |

Imprimer |

jeudi, 17 octobre 2013

Brillant et fougueux commentaire de Nicolas Colin sur l’innovation

Brillant et fougueux commentaire de Nicolas Colin sur l’innovation

http://colin-verdier.com/les-fossoyeurs-de-l-innovation/Peut-être la valeur pédagogique du billet reproduit ci-dessous, donnera-t-elle envie aux modestes et simples citoyens que nous sommes de réfléchir aux façons réellement pragmatiques de bâtir ensemble un avenir moins morne que celui dont on nous rebat les oreilles à longueur de temps.

Les fossoyeurs de l’innovation

http://colin-verdier.com/les-fossoyeurs-de-l-innovation/...

Publié le 15 octobre 2013 par Nicolas Colin

Tout commence comme une sorte de message à caractère informatif. Un collaborateur vient voir le patron d’Orange et lui présente une idée dont il n’est pas peu fier : « Patron, comme nous sommes à la fois une entreprise de média et une entreprise innovante, nous pourrions consacrer une émission de télévision sur notre chaîne Orange Innovation TV aux grands patrons qui innovent dans les grandes entreprises. Ca consisterait à interviewer des dirigeants hyper-innovants et à mettre en valeur leurs innovations par rapport à celles des startups, qui nous donnent beaucoup de leçons mais dont on ne voit pas beaucoup les résultats. D’ailleurs on a déjà trouvé le titre, ça s’appellerait Les décideurs de l’innovation. On a mis au point un super générique à la Top Gun. »

Video http://www.youtube.com/watch?feature=player_embedded&...

Ravi, le patron d’Orange soutient cette idée : « Mon vieux, votre idée est géniale. Je fais banco, vous avez ma carte blanche. J’ai d’ailleurs quelques idées pour les premiers invités, regardons ensemble mon carnet d’adresses pour voir à qui je dois rendre service. »

Video http://www.youtube.com/watch?v=Ps7r26EgdAc&feature=pl...

Parmi ces premiers invités figure justement Nicolas Rousselet, patron des taxis G7 (qui n’opèrent pas que des taxis d’ailleurs, mais aussi une activité de location de voitures, des activités de logistique, de stockage, etc.). Qu’il soit un invité d’une émission aussi audacieuse et disruptive que Les décideurs de l’innovation est un paradoxe : après tout, il est aujourd’hui engagé dans un vaste effort de lobbying pour contrer l’innovation dans le transport individuel de personnes en ville, dans des conditions abondamment détaillées ICIou LA. Quoiqu’il en soit, dans une récente et exceptionnelle édition des Décideurs de l’innovation, Nicolas Rousselet nous expose sa vision de l’innovation.

Video (devenue privée semble-t-il ) http://www.youtube.com/watch?feature=player_embedded&...

Video de remplacement : https://www.decideurstv.com/video/nicolas-rousselet-group...

Et à ce point du billet, mieux vaut en finir avec l’ironie : l’innovation vue par Nicolas Rousselet mérite qu’on s’y attarde tant est elle est dérisoire et erronée à peu près du début à la fin. Voici quelques extraits et mes commentaires :

-

« l’innovation prend deux formes : l’innovation technologique, technique et l’innovation en termes de services, de nouveaux services » (1’50″) – eh bien non, à l’âge entrepreneurial, l’innovation ne prend qu’une seule forme, celle d’une offre nouvelle amorcée et valorisée sur un marché de masse grâce à la mise au point d’un nouveau modèle d’affaires. Les progrès technologiques sans changement de modèle d’affaires ni traction auprès de la multitude s’appellent simplement des gains de productivité… et se commoditisent en un clin d’oeil, sans permettre à l’entreprise de se différencier ;

-

« pour les GPS, tout ça, là on est vraiment à la pointe, ça fait très longtemps qu’on géolocalise tous nos taxis » (3’05″) – non non, si ça fait longtemps qu’on fait quelque chose, alors on n’est pas vraiment à la pointe. Ces derniers temps, les choses changent vite en matière de géolocalisation et de services associés ;

-

« rapprocher le client du taxi, du chauffeur, nécessite de la haute technologie » (3’18″) – pas du tout, ça nécessite tout au plus de l’amabilité de la part du chauffeur et, éventuellement, une application mobile, qui est quasiment à la portée du premier venu d’un point de vue technologique. Bien sûr, ça peut aussi nécessiter de l’innovation, c’est-à-dire un changement du modèle d’affaires : on rapproche d’autant mieux les taxis des clients qu’on fait alliance avec ces derniers, qu’ils sont ainsi incités à être actifs et donc producteurs de données. Cela, ça suppose de la confiance et ça se valorise d’autant mieux que les clients sont nombreux, bien au-delà de la clientèle premium (j’y reviendrai) ;

-

« chaque filiale dans le groupe est gérée de manière autonome, indépendante, par un manager intéressé sur ses résultats » (4’12″) – ce qui est précisément la caractéristique des entreprises non innovantes. L’innovation consiste à combiner de façon différente les composantes de l’activité de l’entreprise, quitte à ce que certaines déclinent si c’est le prix à payer pour le développement de l’entreprise tout entière. Un manager de filiale intéressé sur ses résultats fera tout pour tuer l’innovation dans sa filiale comme dans l’entreprise en général, de façon à protéger sa rente. C’est pourquoi – si du moins l’objectif est d’innover – un manager de filiale ne peut être intéressé au mieux qu’aux résultats de l’ensemble du groupe. Steve Jobs, traumatisé par sa lecture de The Innovator’s Dilemma, l’avait bien compris et mis en pratique depuis longtemps chez Apple, notamment avec la notion de unified P&L ;

-

« nous avons gagné le prix de l’innovation 2010 de la chambre professionnelle du self-stockage » (5’00″) – c’est bien pratique de se créer ses petits prix de l’innovation maison pour faire croire au monde extérieur qu’on est innovant. Mais non, ça ne prend pas. L’innovation, à l’âge de la multitude, ça se mesure aux rendements d’échelle exponentiels et aux positions dominantes sur des marchés globaux. Aucune autre innovation ne contribue de manière significative au développement de l’économie française. Au contraire, le renforcement des situations de rente contribue de manière décisive à la stagnation du revenu par tête et à l’aggravation des inégalités;

-

« on gère les taxis depuis pas loin de vingt ans de manière totalement numérique, avec le GPS » (6’50″) – si les taxis étaient gérés de manière totalement numérique, ils ne s’en tiendraient pas au GPS et auraient inventé Uber avant Uber. Souvenez-vous de cette citation fameuse de The Social Network sur les frères Winklevoss ;

Vidéo http://www.youtube.com/watch?v=ROS0B2q96Xo&feature=pl...

-

« nos chauffeurs de taxi sont tous des indépendants. C’est un vrai partenariat, où la qualité de service est un leitmotiv » (8’00″) – des forums entiers sur la mauvaise expérience des taxis parisiens vécue par les touristes étrangers et les Parisiens eux-mêmes témoignent du contraire – ce qui prouve, par ailleurs, que le fait que les chauffeurs de taxi soient tous indépendants n’est pas forcément la meilleure formule pour assurer une qualité de service maximale. Comme le triomphe d’Apple nous l’a amplement démontré depuis 10 ans, l’unification de l’expérience utilisateur (ou une plateforme bien conçue, comme Amazon) sont les meilleures options pour garantir une qualité de service élevée ;

-

« on a lancé en décembre 2011 le club affaires premium, et là on a même un iPad mis à disposition, on a de l’eau, on a des lingettes » (8’10″) – nous sommes tous très impressionnés, mais il n’y a pas beaucoup d’innovation dans le fait d’enrichir l’offre de service pour les seuls clients qui paient très cher leur abonnement affaires premium. La fuite vers le premium – et le délaissement corrélatif des marchés de masse – est l’un des phénomènes qui détourne les entreprises françaises de l’innovation à l’âge de la multitude – et il y a bien d’autres exemples que les taxis G7. C’est heureux que Nicolas Rousselet assume sans fard qu’il ne s’agit que de fournir aux clients que quelques lingettes et bouteilles d’eau en plus : nous sommes décidément très loin de l’innovation ;

-

« on voit que ça ne roule pas très bien, il y a des gros progrès à faire pour améliorer les conditions de circulation dans Paris » (8’40″) – précisément, on ne roule pas bien dans Paris parce que trop de gens, insatisfaits du fonctionnement des transports en commun et ne pouvant s’offrir les services Affaires Premium Excellence Platine des taxis G7, choisissent de prendre leur véhicule personnel pour leurs déplacements en ville. Le développement des nouveaux modèles d’affaires autour de l’automobile en ville (auto-partage, VTC, etc.) vise en partie à dissuader les individus de prendre leur voiture et peut donc se traduire, à terme, par une décongestion de la circulation à Paris. Que les taxis G7 trouvent que les conditions actuelles sont mauvaises pour les affaires est un comble : d’abord les mauvaises conditions de circulation leur permettent de plus faire tourner le compteur (les taxis ont tout leur temps, ce sont les clients qui sont pressés) ; ensuite, les barrières réglementaires qu’ils défendent à toute force sont précisément la raison pour laquelle il est impossible d’améliorer les conditions de circulation dans cette ville de plus en plus difficile à vivre.

Bref, comme le résume si brillamment ce journaliste particulièrement dur en interview, avec les taxis G7, « ça roule pour l’innovation ». J’ajouterai deux choses sur Nicolas Rousselet et les conditions réglementaires de l’innovation dans les transports urbains :

-

« il faut que les VTC restent sur le métier pour lesquels ils ont été créés » déclarait-il au mois de juillet, cité par un article du Figaro. Wrong again : encore une fois, quand il s’agit d’innovation, l’objectif est précisément de faire bouger les lignes qui séparent les différentes activités et d’en faire la synthèse dans un nouveau modèle d’affaires, centrée autour de l’utilisateur – condition de l’alliance avec la multitude. Le déploiement d’une offre de qualité à très grande échelle est l’objectif stratégique à l’âge entrepreneurial et le seul coeur de métier des startups innovantes, comme nous le rappellent Steve Blank et Paul Graham. Ca n’a aucun sens, dans un monde où la technologie évolue en permanence et où la multitude révèle sans cesse de nouveaux besoins, de demander à une entreprise de rester sur le métier pour lequel elle a été initialement créée. On peut le faire bien sûr, mais il faut assumer alors qu’on renonce à l’innovation – moteur du développement économique, facteur de création d’emplois et de réduction des inégalités et, accessoirement, contribution décisive à l’amélioration du quotidien des consommateurs ;

-

on apprend aujourd’hui, dans un article du Monde, que « le délai de 15 minutes [entre la commande d'un VTC et la prise en charge] s’appliquera à tous les clients des VTC, hormis les hôtels haut de gamme et les salons professionnels ». Belle victoire de lobbying, en tous points contraire à l’intérêt général, et stupéfiante si l’on songe qu’elle a été consentie par un gouvernement de gauche. Si l’on résume la situation, les riches clients du Royal Monceau et les VIP du salon de l’automobile seront servis sans attendre ; par contre, les moins riches attendront ou prendront le bus et les entrepreneurs innovants seront noyés dans la baignoire. (Rappelons encore une fois que l’innovation de rupture arrive toujours ou presque par les activités à faibles marges sur les marchés à faible marge. Si l’on restreint les offres innovantes aux seuls clients premium, il n’y a pas la masse critique pour imposer une innovation de rupture.)

L’innovation meurt d’être mal comprise. Il n’y a pas meilleur contrepoint à la vision de Nicolas Rousselet que les rappels ci-après sur ce qu’est l’innovation, pourquoi elle est importante et comment la favoriser.

L’innovation ne peut pas prospérer en présence de verrous qui rigidifient l’économie et protègent les positions existantes. La seule existence de ces verrous, notamment législatifs et réglementaires, dissuade toute allocation du capital à des activités qui font bouger les lignes dans les secteurs concernés. Quel intérêt d’investir dans une entreprise innovante se développant en France dans le secteur des VTC, puisque le rendement sur capital investi sera dégradé voire annulé par le verrou réglementaire qui protège la rente des taxis ? Il est beaucoup plus rentable d’allouer du capital à une entreprise américaine qui, elle, va triompher des obstacles réglementaires et conquérir un immense marché.

Dans ces conditions, les entreprises américaines prospèrent, tandis que les françaises sont littéralement empêchées de naître. Et lorsque les utilisateurs français (ou les touristes) n’en pourront plus de la mauvaise qualité du service de transport individuel de personnes à Paris et qu’ils obtiendront enfin l’abaissement de la barrière réglementaire, seules les entreprises américaines auront la qualité de service et l’infrastructure nécessaires pour prendre le marché français. (De même que quand la chronologie des médias sera enfin adaptée aux nouveaux modes de consommation des contenus cinématographiques et audiovisuels en ligne, seule Netflix, pas Canal+, sera en mesure de se déployer auprès des utilisateurs français).

Dans un cadre juridique hostile à l’innovation, on voit bien qu’une politique publique de soutien financier à l’innovation est vaine. On peut allouer tout l’argent qu’on veut à OSEO, à BPI France, à la sanctuarisation du CIR et du statut de jeune entreprise innovante, les entreprises ainsi financées ne parviennent pas à lever du capital puisque les gestionnaires de fonds identifient parfaitement les barrières juridiques à l’entrée sur les différents marchés et en déduisent qu’un investissement dans les entreprises concernées ne pourra jamais être rentable. En présence de verrous juridiques protégeant la rente des entreprises en place, l’argent public dépensé pour soutenir l’innovation est comme de l’eau froide qu’on verserait sur une plaque chauffée à blanc : elle s’évapore instantanément.

Le problème serait circonscrit si de tels verrous législatifs n’existaient que pour les VTC. Mais, loin de se cantonner à un seul secteur, ils se multiplient. Les industries créatives sont déjà affectées depuis longtemps par les entraves à l’innovation. Les hôteliers déploient un lobbying à grande échelle pour que la loi soit durcie et les protège sur trois fronts : celui des intermédiaires déjà en place sur le marché de la réservation de chambres d’hôtels ; celui de Google, qui rentre sur ce marché avec Hotel Finder ; celui d’AirBnB, qui intensifie la concurrence sur le marché de l’hébergement en faisant arriver sur le marché les chambres et habitations mises sur le marché par les particuliers. Les libraires semblent en passe d’obtenir une interdiction de livrer gratuitement à domicile les livres commandés via les applications de vente à distance. Bref, à mesure que le numérique dévore le monde, les incendies se déclarent un peu partout et la réponse est toujours la même : on érige une barrière réglementaire qui dissuade l’allocation de capital à des activités innovantes et empêche donc à terme l’émergence de champions français dans ces secteurs.

Sur tous ces dossiers, nous payons très cher l’inexistence d’un lobby français de l’innovation. Il n’est pas du tout évident qu’un tel lobby puisse exister. Aux Etats-Unis, il s’est constitué et il déploie sa puissance en raison d’une double anomalie : les entreprises ont le droit de financer les campagnes électorales ; et les entreprises les plus riches, dont la capitalisation boursière est la plus élevée, sont aussi les plus innovantes. Au lobbying de ces entreprises s’ajoute celui d’une organisation, la National Venture Capital Association, qui défend les intérêts des fonds de capital-risque, y compris contre les intérêts du private equity, des banques d’affaires et des banques de dépôt.

Il n’existe rien de tel chez nous : aucune de nos plus grande entreprises n’est une entreprise innovante, une valeur de croissance comme le sont les géants californiens du numérique ; nos fonds de capital-risque sont rares, dispersés, dilués sur le front institutionnel dans l’Association française du capital investissement ; enfin, les entrepreneurs innovants comme les gestionnaires de fonds de capital-risque sont largement méconnus ou ignorés par les hauts fonctionnaires de la direction générale du Trésor, les membres des cabinets ministériels et, évidemment, les parlementaires.

Il ne peut exister qu’une seule politique publique de l’innovation. Son motif est que l’innovation est le principal facteur de la croissance et moteur du développement économique. Sa règle cardinale est que toutes les décisions de politique publique, sans exception, doivent être prises dans un sens favorable à l’innovation : en matière de financement de l’économie ; en matière de réglementation sectorielle ; en matière de fiscalité et de protection sociale. Aucune autre politique publique que celle-là ne peut être favorable à l’innovation.

Si les exceptions se multiplient, si l’innovation n’est plus qu’une priorité parmi d’autres, si l’on n’abaisse pas les barrières réglementaires à l’innovation de modèle d’affaires, alors notre destin est scellé : notre économie sera bientôt tenue exclusivement par des gens qui, bien qu’ils se prétendent décideurs de l’innovation, en sont en réalité les fossoyeurs.

Nicolas Rousselet, les taxis G7 et tous ceux qui les soutiennent au Parlement ou dans l’administration ne sont qu’un avant-goût de ce sombre avenir : bientôt, notre économie ressemblera à celle de ces pays du Tiers-Monde où l’homme le plus riche du pays, par ailleurs frère ou beau-frère du chef de l’Etat, a fait une immense fortune grâce à un monopole mal acquis sur l’importation des Mercedes d’occasion. Dans une telle configuration, on a tout gagné : des distorsions de marché, l’atrophie de la production locale, une valeur ajoutée réduite à néant, une croissance au ralenti et des inégalités de plus en plus insupportables.

Est-ce cela que nous voulons ? Et sinon, qu’attendons-nous pour agir ?

13:16 Publié dans Économie, Innovation, Numérisation de la société, Régulation | Lien permanent | Commentaires (0) |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook | |

Facebook | |  Imprimer |

Imprimer |

jeudi, 04 juillet 2013

Qualité & Santé (Dominique DUPAGNE)

Qualité et santé : 1) Qualité des moyens ou qualité des résultats ?

Re-publication d’un article sur la Qualité de 2008, à propos de l’affaire des prothèses PIP. À force de se concentrer sur les méthodes et les pratiques de fabrication, on a oublié de vérifier les qualités intrinsèques du produit final. Au sein des agences de régulation, personne n’a pensé à vérifier la composition et les caractéristiques du produit commercialisé. Le texte de l’article initial n’a pas été changé, j’ai juste ajouté cette introduction et l’encadré final. Cet article avait également été publié dans la revue Médecine

Dans le domaine de la santé, le concept de qualité a subi une profonde évolution : initialement centré sur le résultat, il concerne désormais les procédures de soin, aboutissant à leur normalisation.

Ce dossier, divisé en cinq articles, propose une nouvelle approche de la qualité fondée sur un partage et une pondération de la subjectivité. ![]() Ce premier article rappelle la définition de la qualité en santé et son évolution au cours des âges.

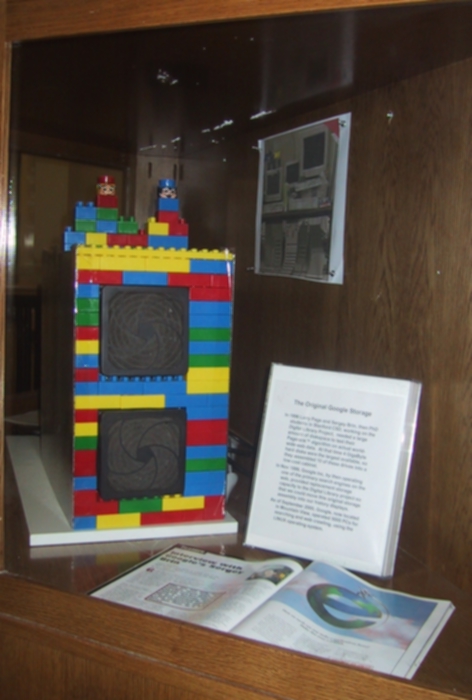

Ce premier article rappelle la définition de la qualité en santé et son évolution au cours des âges. ![]() Le deuxième article fait un détour par le moteur de recherche Google qui a révolutionné le classement de l’information grâce à son approche subjective des critères de qualité.

Le deuxième article fait un détour par le moteur de recherche Google qui a révolutionné le classement de l’information grâce à son approche subjective des critères de qualité. ![]() Dans le troisième article, nous verrons que l’objectivité scientifique, moteur de progrès et de qualité au XXe siècle, atteint aujourd’hui ses limites et doit laisser coexister d’autres approches.

Dans le troisième article, nous verrons que l’objectivité scientifique, moteur de progrès et de qualité au XXe siècle, atteint aujourd’hui ses limites et doit laisser coexister d’autres approches. ![]() La pairjectivité, thème central de ce dossier, est détaillée dans le quatrième article.

La pairjectivité, thème central de ce dossier, est détaillée dans le quatrième article. ![]() Le cinquième article compare nos procédures qualitatives actuelles à un système pairjectif qui a fait ses preuves depuis 500 millions d’années.

Le cinquième article compare nos procédures qualitatives actuelles à un système pairjectif qui a fait ses preuves depuis 500 millions d’années.

Que la stratégie soit belle est une chose, mais n’oubliez pas de regarder le résultat.

Winston Churchill

Le concept de qualité s’est imposé dans l’organisation et la gestion de la santé publique depuis une vingtaine d’années. La qualité s’appelle accréditation, recommandation thérapeutique ou encore évaluation des pratiques professionnelles. Elle fait intervenir des normes, des référentiels et une logistique qui a pour objectif l’amélioration de la qualité des soins. Nous verrons dans ce premier article que cette évolution normative pourrait avoir des effets délétères qui vont à l’encontre de la qualité effective des soins. Les autres articles de ce dossier proposent des solutions pour sortir de cette impasse.

Idées-Forces

![]() Le concept de qualité dans le domaine de la santé a beaucoup évolué : initialement centré sur le résultat, il concerne désormais quasi-exclusivement les procédures de soin.

Le concept de qualité dans le domaine de la santé a beaucoup évolué : initialement centré sur le résultat, il concerne désormais quasi-exclusivement les procédures de soin.

![]() Si c’est l’évaluation de la procédure qui est privilégiée, le risque est grand de voir l’amélioration de la santé des patients passer au deuxième plan.

Si c’est l’évaluation de la procédure qui est privilégiée, le risque est grand de voir l’amélioration de la santé des patients passer au deuxième plan.

![]() Le patient a cédé le pas à la population. Si la procédure est bonne pour la population, elle est censée être applicable à chaque patient. Cette approche réductrice nie la singularité de l’Humain.

Le patient a cédé le pas à la population. Si la procédure est bonne pour la population, elle est censée être applicable à chaque patient. Cette approche réductrice nie la singularité de l’Humain.

![]() La subjectivité a été progressivement bannie de l’évaluation scientifique. Or la médecine est une science de l’Homme qui est fondamentalement un sujet et non unobjet.

La subjectivité a été progressivement bannie de l’évaluation scientifique. Or la médecine est une science de l’Homme qui est fondamentalement un sujet et non unobjet.

De l’obligation de résultat à l’obligation de moyens

En matière de soins, la qualité a longtemps été synonyme d’efficacité. Un groupe de travail de l’ENA a publié en 2003 un document sur l’évaluation et la qualité en santé [1]. Une annexe regroupe des citations intéressantes au sujet de sa définition [2] :

1792-1750 av JC Si un médecin opère un homme pour blessure grave avec une lancette de bronze et cause la mort de l’homme ou s’il ouvre un abcès à l’oeil d’un homme avec une lancette de bronze et détruit l’oeil de l’homme, il aura les doigts coupés. Article 218 du Code d’Hammourabi.

1980 Les soins de haute qualité sont les soins visant à maximiser le bien-être des patients après avoir pris en compte le rapport bénéfices/ risques à chaque étape du processus de soins, Avedis Donabédian.

1990 Capacité des services de santé destinés aux individus et aux populations d’augmenter la probabilité d’atteindre les résultats de santé souhaités, en conformité avec les connaissances professionnelles du moment.Institute of Medecine.

2000 Aptitude d’un ensemble de caractéristiques intrinsèques à satisfaire des exigences. ISO 9000.

L’évolution de la notion de qualité est frappante :

![]() La première définition résume grossièrement (et brutalement...) le concept de qualité médicale tel qu’il a prévalu pendant des millénaires : seul le résultat du soin sur le patient est pris en compte

La première définition résume grossièrement (et brutalement...) le concept de qualité médicale tel qu’il a prévalu pendant des millénaires : seul le résultat du soin sur le patient est pris en compte ![]() La deuxième introduit conjointement la notion de rapport bénéfices/risques. Avec cette notion statistique, le pluriel apparaît aussi bien pour le soin que pour le patient dont la singularité s’estompe.

La deuxième introduit conjointement la notion de rapport bénéfices/risques. Avec cette notion statistique, le pluriel apparaît aussi bien pour le soin que pour le patient dont la singularité s’estompe. ![]() La troisième définition se déconnecte du résultat : c’est la méthode, le processus qui sont importants, il devient possible d’associer des soins de qualité à un échec thérapeutique pourvu que la probabilité de succès ait été élevée a priori. C’est l’obligation de moyens qui prime et prodiguer des soins "appropriés" devient le principal critère de qualité. Le malade peut mourir pourvu qu’il ait été "bien soigné" [3]. Enfin, la définition n’est plus centrée sur l’individu, elle parle désormais de "populations".

La troisième définition se déconnecte du résultat : c’est la méthode, le processus qui sont importants, il devient possible d’associer des soins de qualité à un échec thérapeutique pourvu que la probabilité de succès ait été élevée a priori. C’est l’obligation de moyens qui prime et prodiguer des soins "appropriés" devient le principal critère de qualité. Le malade peut mourir pourvu qu’il ait été "bien soigné" [3]. Enfin, la définition n’est plus centrée sur l’individu, elle parle désormais de "populations". ![]() La dernière élude totalement la notion de résultat. C’est "l’exigence" qui compte désormais. Exigence du malade ou exigence de la norme ? La réponse a été apportée par la mise en pratique de la certification ISO : le malade (ou patient, ou client) est réputé avoir une forte probabilité d’être satisfait si les exigences de qualité du processus sont remplies. L’évaluation ne fait plus intervenir le destinataire du "service soin".

La dernière élude totalement la notion de résultat. C’est "l’exigence" qui compte désormais. Exigence du malade ou exigence de la norme ? La réponse a été apportée par la mise en pratique de la certification ISO : le malade (ou patient, ou client) est réputé avoir une forte probabilité d’être satisfait si les exigences de qualité du processus sont remplies. L’évaluation ne fait plus intervenir le destinataire du "service soin".

En vingt ans, la qualité a glissé de l’obligation de résultat vers celle de moyens, de l’appréciation extrinsèque du soin par le patient à l’analyse intrinsèque du mode opératoire au regard d’une norme. La qualité d’une action de soin est désormais déconnectée de son résultat [4].

Dans le même temps, l’introduction de notions statistiques conduit la qualité à s’éloigner de l’individu pour s’intéresser aux populations. La diversité des souffrants et des approches thérapeutiques est niée par la normalisation du soin.

La Qualité devenant une entité autonome a envahi le champ professionnel et notamment sanitaire [5] :démarche qualité, groupes qualité, accréditations et certifications sont omniprésents, s’accompagnant dereprésentants qualité, médecins habilités [6] et autres qualiticiens. Mais la démarche qualité en santé n’est pas simple à appliquer et ne génère pas l’enthousiasme des soignants [7].

La notion de progrès médical, omniprésente pendant les trente glorieuses, a subi un recul concomitant de l’irruption de la qualité dans le champ sanitaire.

Ce déplacement du progrès vers la qualité n’est pas anodin. Le progrès est palpable, visible par le public. C’est une notion concrète proche de celle du résultat. Si les octogénaires sont si friands de médicaments, c’est en partie parce qu’ils ont vu disparaître la polio et la diphtérie, guérir la tuberculose et les pneumonies. Ce progrès médical était d’une telle évidence depuis la dernière guerre mondiale que la notion de qualité n’avait pas de sens. Le prix de la santé paraissait justifié par ses progrès et l’augmentation de son coût accompagnait celle du niveau de vie des populations.

Malheureusement, le coût de la santé croît plus vite que le PIB, aboutissant à des prélèvements sociaux préoccupants qui conduisent désormais à s’interroger sur le rapport coût/efficacité des soins et donc à souhaiter évaluer leur qualité [8].

Les médecins se sont longtemps plaints de la dictature de la salle d’attente, dont la fréquentation était censée servir de baromètre à leur qualité. Ils sont désormais soumis à la dictature de la norme : peu importe le résultat final de leurs soins et le bien-être du patient. Il faut désormais passer sous les fourches caudines de la "recommandation" [9] érigée en recette de soin obligatoire et rédigée par des experts [10].

Ont-ils gagné au change ? Les patients en tirent-ils un bénéfice ? Rien n’est moins sûr et des voix s’élèvent de tous côtés [11] contre cette réduction de l’art médical à son plus petit dénominateur commun. Censée gommer les différences, la norme aboutit en fait à scléroser la part humaniste du soin et la richesse que constitue la variété des approches, tout en créant une fausse sécurité.

Il est d’ailleurs frappant de voir les partisans de la normalisation du soin se référer à l’EBM [12]. Les "inventeurs" de l’EBM déclaraient dans leur article fondateur leur opposition ferme à la transformation de l’EBM en "livre de recettes de cuisine médicales" [13], prémonition qui se révèle tristement d’actualité.

Qualité interne et qualité externe

La place croissante de la prise en compte des procédures dans l’évaluation de la qualité a conduit à sa segmentation en qualité interne et qualité externe

![]() La qualité externe, correspond à l’amélioration du sort des patients, individuellement ou en tant que groupe. C’est la qualité fondée sur des critères extérieurs au soin lui-même. Il s’agit de fournir des services conformes aux attentes des patients. Ce type de démarche passe ainsi par une nécessaire écoute des patients mais doit permettre également de prendre en compte des besoins implicites, non exprimés par les bénéficiaires.

La qualité externe, correspond à l’amélioration du sort des patients, individuellement ou en tant que groupe. C’est la qualité fondée sur des critères extérieurs au soin lui-même. Il s’agit de fournir des services conformes aux attentes des patients. Ce type de démarche passe ainsi par une nécessaire écoute des patients mais doit permettre également de prendre en compte des besoins implicites, non exprimés par les bénéficiaires. ![]() La qualité interne, correspond à l’amélioration du fonctionnement interne de la structure de soins. L’objet de la qualité interne est de mettre en oeuvre des moyens permettant de décrire au mieux l’organisation, de repérer et de limiter les dysfonctionnements et de soigner au meilleur coût. Les bénéficiaires de la qualité interne sont la direction et les personnels de la structure, ainsi que ses financeurs. Le destinataire final du soin, le patient, est le plus souvent exclu de la démarche [14].

La qualité interne, correspond à l’amélioration du fonctionnement interne de la structure de soins. L’objet de la qualité interne est de mettre en oeuvre des moyens permettant de décrire au mieux l’organisation, de repérer et de limiter les dysfonctionnements et de soigner au meilleur coût. Les bénéficiaires de la qualité interne sont la direction et les personnels de la structure, ainsi que ses financeurs. Le destinataire final du soin, le patient, est le plus souvent exclu de la démarche [14].

L’imposition d’une évaluation qualitative fondée sur le respect de la norme est en grande partie imputable aux médecins. S’appuyant sur un siècle de progrès médical continu, ceux-ci ont toujours refusé toute forme d’évaluation de la qualité externe, c’est-à-dire de leur activité personnelle. Les financeurs, confrontés à des déficits sociaux croissants, ont donc investi le champ de la qualité interne et tentent actuellement de l’imposer comme principal mécanisme de régulation des dépenses [15].

Or nous sommes désormais arrivés à une évaluation de la qualité exclusivement interne, ce qui constitue un véritable piège dans lequel notre système de santé [16] s’enferme progressivement.

La médecine est un art autant qu’une science. Supprimer l’évaluation de la qualité externe au prétexte de sa subjectivité est une erreur. Cette erreur est issue d’une démarche scientifique ayant dépassé son objectif, tel le balancier dépassant son point d’équilibre. Exclu des processus décisionnels, le patient est également exclu de la mesure de la qualité [17].

Les redoutables effets latéraux de la mesure interne de la qualité

L’évaluation imparfaite de la qualité des soins par référence obligatoire à la norme aboutit à un nivellement par le bas du soin, car la norme est finalement le plus petit dénominateur commun de la qualité. Cette évaluation réductrice étant couplée à une contrainte croissante (financière, administrative, réglementaire), elle conduit à trois types d’effets latéraux redoutables : ![]() Les meilleurs soignants sont incités à abandonner leurs processus de qualité personnels pour respecter une norme qui dégrade leurs soins. De plus, ils vivent cette injonction comme profondément injuste et se découragent. Leur productivité diminue d’autant.

Les meilleurs soignants sont incités à abandonner leurs processus de qualité personnels pour respecter une norme qui dégrade leurs soins. De plus, ils vivent cette injonction comme profondément injuste et se découragent. Leur productivité diminue d’autant. ![]() Certains soignants médiocres apprennent à respecter la norme pour recevoir les ressources financières associées au "parcours vertueux". L’application de la norme n’est alors plus motivée par la recherche de la qualité et peut dissimuler une altération du soin. Ces acteurs de non-qualité parviennent à capter massivement les ressources par une intelligence dédiée à l’application de la norme et non à l’amélioration de la santé.

Certains soignants médiocres apprennent à respecter la norme pour recevoir les ressources financières associées au "parcours vertueux". L’application de la norme n’est alors plus motivée par la recherche de la qualité et peut dissimuler une altération du soin. Ces acteurs de non-qualité parviennent à capter massivement les ressources par une intelligence dédiée à l’application de la norme et non à l’amélioration de la santé. ![]() Une part croissante des ressources de la structure de soin est monopolisée par les processus de mesure de la qualité interne. Ce détournement aboutit à une détérioration de la productivité globale de la structure de soin. La productivité est pourtant un élément réputé important de cette qualité interne [18]